近年來大型語言模型(LLM)和生成式 AI 在全球企業中的採用率大幅攀升。根據 McKinsey 於 2024 年初的調查,約 65% 的組織 已經在日常運營中定期使用生成式 AI,這個比例較前一年幾乎翻倍。同時 Gartner 的研究也指出,企業導入生成式 AI 技術有望在未來一年內節省約 15.7% 的營運成本。這些數據顯示 AI 技術正快速融入各領域,不僅帶來效率提升,也讓企業對其商業價值抱持高度期待。

然而,伴隨著 AI 普及而來的是應用整合的痛點:再先進的模型,如果無法連接現有系統與資料,就如同受困於資訊孤島,難以充分發揮作用。事實上,許多組織發現,每新增一個資料來源,都需要開發人員客製不同的整合介面,導致整合流程分散且不易擴充。

為了解決這項瓶頸,Anthropic 等業界先驅提出了 Model Context Protocol(MCP) 作為通用的 AI 整合管道,希望以單一開放標準來取代過去零散繁瑣的客製整合方式。接下來,我們將深入介紹 MCP 的原理與應用,說明它如何成為連結 AI 與各種工具資料的關鍵方案。

MCP 是什麼?

Model Context Protocol(MCP) 是 2024 年由 Anthropic 發起的一項開放標準,其目的是讓 AI 助手能夠方便、安全地連接到各種外部系統與資料來源。簡而言之,MCP 就像 AI 世界的 USB-C 通用接口:過去不同裝置需要各自的轉接頭,現在透過 USB-C 就能統一連接;同樣地,有了 MCP,智慧型 AI 工具可以透過標準化接口存取不同平台的資料與功能。這讓 AI 模型在回答問題時,不再局限於訓練語料,還能動態調用外部資訊,產生更相關有用的回應。

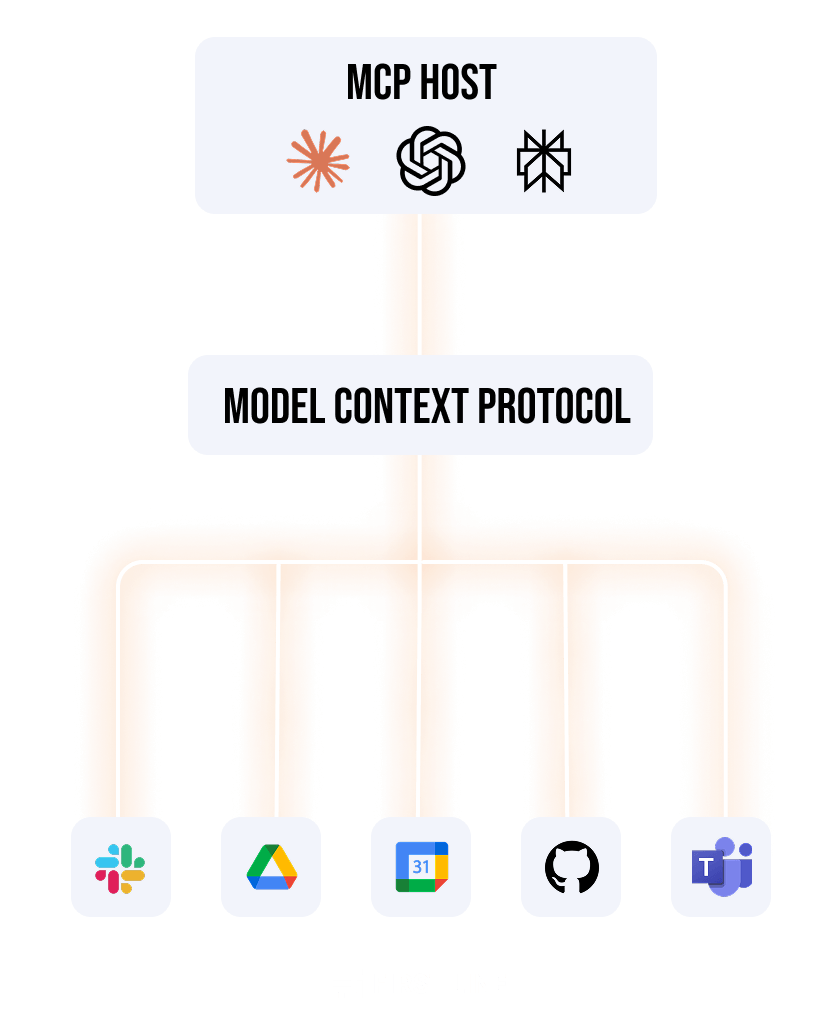

從架構上看,MCP 採用用戶端-伺服器(Client-Server)模型:

- MCP 伺服器(Server)指的是對外提供特定資源或功能的服務模組。例如,可以有一個 MCP 伺服器實現「Google 行事曆服務」,提供查詢行程的函式(Tool),或一個「資料庫服務」提供查詢資料的資源。換言之,任何能對模型提供工具或資料的程式,都可以是 MCP Server。

- MCP 用戶端(Client)通常是內建於 AI 應用中的智慧代理(如對話式助手、智慧 IDE 助手等),負責發現並呼叫 MCP 伺服器提供的功能。例如,一個程式碼助理會作為 MCP Client,去「發現」目前有哪些工具可用,並根據使用者需求去喚起相應工具的功能。使用者輸入的自然語言請求,透過用戶端的橋接,轉換成對伺服器的函式調用,最後再把結果回饋給使用者。

- Schema(結構定義)則是 MCP 中用來描述伺服器可用功能和資料結構的藍圖。每個 MCP 伺服器會以標準格式定義自己有哪些工具(函式)可以被呼叫、需要哪些輸入參數,以及可能的輸出結果類型。這種標準化的資料格式讓 AI 模型可以理解如何使用伺服器提供的功能。換句話說,Schema 就像 API 文件的機器可讀版本,清楚規範了 AI 助手和伺服器溝通時應遵循的「語法」。因為有 Schema 的約定,開發者和模型都能知道工具如何調用,不需要再為每個整合撰寫説明文件。

透過上述組件,MCP 建立了一套安全雙向連接的架構,讓開發者可以選擇「將自己的資料或服務封裝成 MCP 伺服器對外提供」,或「打造能對接各種 MCP 伺服器的 AI 應用(Client)」。這種彈性意味著,不論是擴充既有系統的 AI 存取能力,或是開發全新的 AI 工具,都可以在 MCP 的統一標準下進行。

與傳統 API 的差異

MCP 提供的體驗和傳統 API 整合有明顯差異,可以從使用方式、安全性與開發成本三方面來比較:

- 使用方式:傳統上,開發者若想讓 AI 模型使用外部功能,必須針對每個第三方服務編寫特定的 API 調用程式碼,就像為每種設備準備不同轉接頭一樣繁瑣。而 MCP 的角色更像「通用延長插座」,提供單一介面讓 AI 助手隨插即用各種工具。更重要的是,AI 代理不必事先「知道」要使用哪個 API 或寫死調用邏輯,因為 MCP 容許 AI 透過自然語言來動態探索並呼叫所需的工具。換言之,MCP 讓 AI 能自行發現適合解決當前任務的工具,而不需要我們預先硬編程每一種可能的整合。這種以語意驅動、即插即用的使用模式,大幅提升了 AI 系統在複雜場景下的適應力。

- 安全性:在傳統整合中,不同 API 的身份驗證與授權機制各異,開發者往往需要為每個服務單獨處理 API 金鑰或 OAuth 流程,稍有不慎便可能埋下資安風險。MCP 則將許多認證與授權細節納入標準化管道中處理。例如,MCP 協定本身鼓勵使用既有的 OAuth2 機制來讓使用者授權 AI 存取其帳戶資料,而非將長效性的 API Token 暴露給模型。在工具調用過程中,MCP 也統一採用結構化的請求/回應格式,確保資料傳輸井然有序並便於監控。相較之下,傳統 API 整合因缺乏統一的上下文,可能出現權限過大或資料亂流的情況,而 MCP 則致力於提供一致的安全規範來保護用戶資料與操作。

- 開發維度:從開發者角度看,MCP 可以顯著降低整合成本。以前我們為每個新工具都得寫一次重複的對接程式,如今只需「對接一次,處處使用」。開發者可以依照標準協定構建一次 MCP 伺服器或連接器,之後各種 AI 客戶端(不論是對話機器人還是編輯器助手)都能重複使用該整合。這意味着開發人員不必為不同的AI平台各寫一套介接程式碼,同一套 MCP 插件可以同時支援多個模型與平台。事實上,Microsoft 與 OpenAI 等公司已承諾採用相同的外掛標準,讓 Bing Chat、Microsoft Copilot 等與 ChatGPT 能共用插件生態。對開發者而言,這種標準化互通代表著更高的回報:一旦開發出符合 MCP 標準的整合工具,它就有機會在不同應用和環境中被廣泛使用,而無需進行「一百種不同方式的重寫」。這不僅減少重複勞動,也促進了一個可持續發展的整合生態系。

| 比較面向 | RESTful API | Model Context Protocol(MCP) |

|---|---|---|

| 整合對象 | 面向人類開發者或應用程式設計 | 面向 AI 模型與代理工具設計 |

| 呼叫方式 | 需明確撰寫 API 調用邏輯與參數設定 | 可由模型透過語意理解與上下文自動選擇合適工具 |

| 權限與安全 | 常以 API Key / OAuth2 各自實作 | 採一致格式與權限流程(多鼓勵 OAuth2),方便模型操作 |

| 維護模式 | 各系統獨立設計與對接,自由度高但需手動調整 | 標準化 Schema 與插件結構,可重用於多平台 AI 應用 |

| 適用場景 | 適合高自訂、精細邏輯控制的整合需求 | 適合需要語意調用、多工具連動的 AI 工具情境 |

總的來說,MCP 帶來的是一種更聰穎且友好的整合模式。它讓 AI 工具的使用更加靈活(可自行找工具)、更安全有序(統一授權與資料格式)、且開發效率更高(一次開發,多處運用)。隨著愈來愈多平台採用共同標準,我們正朝向一個AI 工具互相兼容的時代邁進,這是傳統封閉式 API 無法輕易實現的。

實際應用案例

MCP 已逐漸在各類實際場景中展現價值,以下列舉幾個應用案例,說明 MCP 如何整合常見工具與服務:

- Google Drive / Slack / GitHub:Anthropic 已開源提供多種常用平台的 MCP 伺服器範例,包括 Google Drive、Slack、GitHub 等。透過這些插件,AI 助手可以直接讀取使用者 Google 雲端硬碟中的文件、存取團隊 Slack 頻道裡的聊天記錄,或查詢 GitHub 儲存庫的程式碼與專案資訊,無需人工手動切換應用。例如,當使用者詢問「總結一下最新的企劃文件」時,AI 可自動經由 MCP 連接 Google Drive 插件取得該文件內容,再進行摘要;又或者在程式開發中,AI 助手能透過 GitHub 插件檢索最近一次 commit 的變更紀錄,協助開發者了解代碼更新重點。這些應用都證明了 MCP 如何成為 AI 學習環境與實際資料之間的橋樑。

- Microsoft Copilot 與跨平台外掛:在企業級應用方面,大廠也開始擁抱 MCP 概念。Microsoft 在 Build 2025 開發者大會上宣布,Windows 11 將把 MCP 納入其智慧代理架構的基石,為日後各類 AI 助理在 Windows 環境中執行跨應用操作提供統一管道。此外,Microsoft 亦承諾其 Bing Chat 以及 Microsoft 365 Copilot 平臺將採用與 OpenAI ChatGPT 相同的外掛標準。這意味著開發者為某項服務開發的MCP 插件,未來可同時被 ChatGPT 與 Microsoft Copilot 等多個 AI 助手共用,真正實現一次開發、處處運行的願景。想像一個情境:您在 Excel 中使用 Copilot 安排會議日程,Copilot 透過 MCP 插件從您的 Google Calendar 取得空閒時段,並自動發送 Teams 邀請;這種不同產品之間的協作,都將因為共享的 MCP 外掛生態而變得順暢。而目前 Microsoft 已與 OpenAI 攜手推動這一生態系統,可預期更多第三方服務(如雲端資料庫、CRM 系統等)會跟進提供 MCP 標準的插件,豐富 Copilot 與其他 AI 平台的功能。

上述案例展現了 MCP 在個人效率工具(如雲端硬碟、團隊通訊)和開發者工作流(版本庫、協同編輯)中的應用潛力。不論是個人用戶將 AI 助手串聯日常應用,或是企業將 AI 整合進現有系統,MCP 都提供了一條安全且通用的捷徑來實現這些整合。隨著更多廠商加入 MCP 生態,我們將看到 AI 助手擁有日益豐富的「能力清單」,可以即時調用各種外部服務來滿足使用者需求。

想像一下,當你對 AI 助手說出「總結一下最新的企劃文件」這樣的請求時,它會先判斷需要從哪裡取得資料,接著透過 MCP 標準找到對應的 Google Drive 插件。AI 不需事先寫死指令或查 API,而是能動態找到能幫忙的插件。找到之後,它會用這個插件自動搜尋你的雲端硬碟,定位最新的企劃文件,接著讀取檔案內容並產出重點摘要。這整個過程不需要你打開應用程式或手動上傳檔案,AI 就能像個有讀寫能力的助理,聰明地幫你處理完畢。

技術實作概念

從技術角度看,MCP 的實現建立在成熟的網路通訊基礎上,又有其特殊的設計考量。MCP 採用 JSON-RPC over HTTP 的通訊方式,也就是以 JSON 結構封裝請求與回應,透過 HTTP 傳輸。這種選擇使得 MCP 請求非常輕量且易於解析,同時具備與傳統 Web API 相近的互通性。以下我們以一個簡化流程來說明 MCP 外掛(插件)的工作原理:

工具發現

當 AI 助手(MCP Client)啟動或面臨一項任務時,它會先查詢已連接的 MCP 伺服器有哪些可用的工具。這通常透過一個如「tools/list」的方法來實現。舉例而言,客戶端發送如下的 JSON-RPC 請求給某個 MCP 伺服器:

POST /mcp/jsonrpc HTTP/1.1

Host: api.example.com

Content-Type: application/json

{

"jsonrpc": "2.0",

"id": 1,

"method": "tools/list",

"params": {}

}伺服器接收到請求後,會回傳一個 JSON 結構,列出它提供的所有工具。例如某個天氣服務的伺服器可能回應:

{

"jsonrpc": "2.0",

"id": 1,

"result": [

{

"name": "get_weather",

"description": "Retrieves weather data.",

"schema": {

"type": "object",

"properties": {

"location": { "type": "string" }

},

"required": ["location"]

}

}

]

}其中每個工具都包含名稱、功能描述,以及輸入參數的 schema(例如需要一個字串類型的location地點參數)。透過這個工具清單,AI 模型就明白伺服器能做什麼以及如何呼叫。

函式調用

接下來,當 AI 模型決定使用某個工具(通常是因為使用者的提問觸發了相關需求,例如「今天臺北的天氣如何?」),MCP 客戶端會根據工具清單發起相應的函式呼叫請求。例如,上例中若模型要使用 get_weather 工具,它會向伺服器發送:

POST /mcp/jsonrpc HTTP/1.1

Host: api.example.com

Authorization: Bearer <token>

Content-Type: application/json

{

"jsonrpc": "2.0",

"id": 2,

"method": "tool/execute",

"params": {

"tool": "get_weather",

"params": { "location": "Taipei" }

}

}MCP 伺服器收到這個帶參數的調用請求後,將執行對應的函式邏輯(比如調用天氣 API 拿取臺北天氣),並把結果封裝在 JSON 結構中返回給客戶端。

結果回傳與整合

伺服器執行完工具後,會透過 JSON-RPC 回應傳回結果。例如:

{

"jsonrpc": "2.0",

"id": 2,

"result": {

"temperature": 25,

"condition": "partly cloudy"

}

}MCP 客戶端收到結果,會將這段資訊納入 AI 模型的上下文中,然後模型便能據此產生最終回答(例如:「臺北今天25度,多雲。」)。這整個過程對使用者來說是透明的——他們只看到 AI 助手給出了準確答案,殊不知背後 AI 已透過 MCP 即時查詢了外部資料。

值得注意的是,在這個雙向交換過程中安全與控制是有保障的。模型只能呼叫伺服器事先暴露出的特定工具,任何請求與資料都經由定義好的協定通道傳遞,不會越權訪問未授權的功能。同時,客戶端(宿主應用)通常會充當一個監管者,仲介模型與伺服器的互動:它根據模型意圖構造 MCP 請求,獲得伺服器回應後再交給模型使用。整個 MCP 執行流程採用了結構化、標準化的步驟,使 AI 調用外部工具就像人類使用作業系統提供的 API 一樣順暢自然,但又保有嚴謹的權限控制和錯誤處理機制。

使用者 → 模型(MCP Client) → MCP Schema → MCP Server → 回傳結果

概括而言,MCP 插件的實作包含定義 Schema(工具清單與參數結構)、處理 JSON-RPC 通訊,以及在伺服器端實現實際功能邏輯這幾部分。由於 MCP 協定已經規範了通訊格式與流程,開發者可以專注於伺服器端功能的實現,無需關注模型端如何解讀,因為模型會按照標準自動理解。這種清晰的分層也讓 MCP 插件的調試與維護更為容易。

安全性與最佳實務

由於 MCP 讓 AI 模型得以觸及用戶私人資料和敏感操作,其安全性不容輕忽。所幸 MCP 從設計之初就將許多資安考量納入標準,同時社群與企業也提供了最佳實務來確保整合過程的安全。以下我們探討幾個重要面向:

| 授權與驗證 | MCP 採用現有成熟的授權框架(如 OAuth2)來保護使用者資料。典型作法是當 AI 第一次嘗試存取用戶帳戶資料(例如 Google Drive 檔案)時,會跳出 OAuth2 授權流程讓使用者明確同意。而在 MCP 標準的早期推行中,不同開發者對認證方式的實作可能略有差異,導致 OAuth 機制尚未完全強制統一。為避免這種「認證落差」,最佳實務是始終使用 OAuth 等標準協議進行授權,不採用臨時硬編碼的憑證。這可確保 AI 存取受限於用戶明示允許的範圍,第三方服務也能提供細粒度的權限管理。此外,開發者應避免讓 AI 代理直接持有長期有效的存取令牌,最好將敏感憑證妥善保管於受控環境,由後端代理代為存取,防止令牌洩露風險。 |

| 使用者掌控與透明度 | 「使用者永遠保有最終控制權」是 MCP 安全原則之一。所有經 AI 代理進行的敏感操作,都應該在執行前明確告知並徵求使用者同意。例如,若 AI 插件嘗試修改或刪除檔案,介面上應提醒使用者並要求確認後才執行。同時,操作過程需可被審計:開發者應建立日誌紀錄 AI 代理替使用者執行過的每一步動作,以備日後追蹤。Microsoft 在 Windows 11 MCP 安全架構中就強調,代理執行的所有涉及系統狀態變更、資料存取的行為都要對使用者透明且可追溯。這代表實務上開發者應在應用界面上提供可檢視的活動記錄,或在企業環境下將 MCP 操作日誌納入既有監控系統。透過讓使用者知情並記錄行為,可大幅提升信任度並及早發現異常。 |

| 最小權限原則 | 開發者在實作 MCP 插件時,應堅守Least Privilege(最小權限)原則,即僅賦予 AI 完成任務所需的最低權限。例如,如果某 MCP 插件只需要讀取資料而非修改,那麼就應該將其權限限制為唯讀。Windows 11 的 MCP 平台將強制要求插件宣告自身所需的能力範圍,並透過沙盒或進程隔離等手段,將其影響侷限在最小範圍。對於開發者而言,這意味著要在 Schema 或插件清單中清楚定義每個工具的作用域(例如只能讀取不能寫入、只能訪問特定資料庫而非整個檔案系統)。如此一來,即便某個 MCP 伺服器遭到入侵,其能造成的損害也被限制在最低程度,不致影響整個系統或其他服務。 |

| 防範常見威脅 | 由於 AI 代理透過自然語言與各種資料交互,一些新的安全風險也隨之出現。國際網路安全組織 OWASP 已經彙整了 LLM 應用的十大風險,其中包括Prompt Injection(提示注入)攻擊、資料洩露、沙箱逃逸、未經授權的程式執行等。對 MCP 而言,Prompt Injection 特別值得關注:惡意者可能透過巧妙設計的輸入,誘使模型生成不受控的工具調用指令,造成越權操作。例如在聊天對話中嵌入隱藏指令,引導 AI 調用檔案刪除工具。為減緩此風險,開發者應對所有來自模型或使用者的輸入進行嚴格驗證與過濾。MCP 伺服器收到請求後,應檢查參數是否在允許範圍內,對文字輸入要避免直接拼接形成系統命令,以防範指令注入。同時,對於模型回傳的工具執行請求,客戶端也應該設置白名單或沙盒機制,確保代理只能執行預期內的操作。總之,輸入消毒、輸出過濾、行為沙盒等經典安全措施在 MCP 環境下依然適用,而且更加重要。 |

歸納上述,MCP 的安全體系是多層防護的結果:一方面透過標準規範(如 OAuth2、Scope 定義)將保護關卡前置,另一方面仰賴開發者在實作時遵循最佳實務(如最小權限、審計日志、輸入校驗)來減少潛在漏洞。大廠如 Microsoft 也在為 MCP 打造更健全的安全生態,例如計畫引入中央代理來統一攔截所有 MCP 流量並執行政策控管、建立受信任的伺服器註冊中心只允許通過安全稽核的插件上架等等。可以預見,隨著 MCP 普及,相關的安全工具和框架也會同步演進,為用戶和企業打造一個既開放靈活又安全可靠的 AI 整合環境。

開源社群與資源

MCP 從誕生之初就帶有濃厚的開源與社群協作基因。Anthropic 已將 MCP 的核心規範與工具全數以開源方式公開,任何人都可以查看協定細節並參與貢獻。以下是目前 MCP 在開源生態與社群資源方面的概況:

- 開源實作:目前 MCP 的官方 GitHub 組織(

modelcontextprotocol)提供了一系列開源專案,包括協定規範、開發者 SDK 和各種範例伺服器實作。其中一個重點是「MCP 伺服器範例倉庫」,內含多種常見服務的連接器,例如 Google Drive、Slack、GitHub、Postgres 資料庫、瀏覽器自動化(Puppeteer)等等。這些範例讓開發者可以直接參考或使用,快速為自己的 AI 應用增添對應的整合能力。值得一提的是,Anthropic 官方表示已經與一些企業和開發工具團隊合作,開發適用於他們平臺的 MCP 服務端,例如 Block(金融科技公司)和 Apollo(投資公司)率先將 MCP 整合進內部系統,Zed、Replit、Codeium、Sourcegraph 等開發者工具也在打造 MCP 插件。這些開源實作與企業合作不僅豐富了 MCP 插件的類型,也驗證了 MCP 規範在不同環境下的可行性。 - 社群參與:MCP 項目歡迎各界開發者參與其發展。開源庫中提供了詳細的 Contributing 指南,開發者可透過提交 Pull Request 為 MCP SDK 或伺服器實作貢獻代碼、回報問題或提出新功能需求。除此之外,Anthropic 也設置了社群論壇和交流渠道(如 Slack 討論群組),方便開發者彼此討論使用經驗、分享範例或向核心團隊提問。這種開放的社群氛圍使 MCP 不僅是一項標準,更是一個由眾人協力打造的生態系專案。正如 Block 公司的技術長所言:開源不只是開發模型,而是打造以協作為根基的技術橋梁;像 MCP 這樣的開放技術能連結 AI 與真實應用,確保創新能以透明且合作的方式普惠大眾

- 學習資源:對於想進一步了解或上手 MCP 的開發者,有豐富的資源可供利用。官方文件網站(modelcontextprotocol.io)提供了完整的協定說明、使用指南和教學範例。開源庫中則有各語言版本的 SDK 工具,例如 TypeScript、Python、Java、Kotlin、C# 等官方實作(其中 C# SDK 還是與 Microsoft 合作維護的),方便開發者在熟悉的語言環境下構建 MCP 插件。除此之外,社群也產出了許多優質的第三方教學文章與影片:如 OpenCV 發布的《MCP 初學者指南》、Humanloop 與 WorkOS 等技術部落格對 MCP 的解析文章,深入淺出地解釋了 MCP 的運作並提供了示範程式碼。如果您對 MCP 有興趣,不妨從官方文件開始,搭配這些社群資源一步步實作屬於自己的 MCP 插件。此外,加入 MCP 的社群頻道保持關注,也是掌握最新進展與活動的好方法——畢竟在這個快速演進的領域,一起討論與交流能讓學習事半功倍。

總而言之,開源與社群力量是 MCP 能夠快速發展的原因之一。開放的協定規範讓各家廠商和個人都能貢獻創意;共享的實作範例則加速了應用普及。隨著越來越多人參與,我們有理由相信 MCP 生態將更加繁榮多元,持續推出新的插件、工具和最佳實踐,讓 AI 智慧助手真正無所不在地接入我們的數位生活。

結語與未來趨勢

從上述分析可以看出,Model Context Protocol(MCP)為 AI 應用整合帶來了統一且強大的解決方案。它解決了大型語言模型落地時「資料孤島」與「工具碎片化」的難題,提供了如同 USB-C 般通用的智慧整合管道。隨著 AI 代理(Agentic AI)的興起,未來我們將看到越來越多 AI 助手在不同平台間協同工作,彼此交換訊息、自主執行任務。而要實現這樣的「AI 生態系統」,互通的標準框架將扮演關鍵角色。國際研究機構 Forrester 就指出:「就像網際網路的爆炸性成長離不開標準協定,讓 AI 代理實現全球互聯同樣需要共享的框架」。目前各家 AI 系統仍多半在自己的園地內運作,缺乏跨平台的協作標準,導致 AI 代理可能淪為一座座孤島,無法形成真正連結的智慧網絡。因此,建立代理間的互操作性是業界共同的目標。

MCP 正是這股趨勢中的先行者之一——Forrester 分析師將 Anthropic 的 Model Context Protocol 稱為實現 AI 工具與資料無縫整合的標準範例。它讓不同廠商、不同環境下的 AI 系統,都有機會透過共同語言協同運作,避免受制於某一家供應商或僵化的硬編碼邏輯。未來幾年,我們有望看到更多類似 MCP 的開放標準湧現,或者 MCP 本身成為事實上的業界標準。屆時,不論您使用的是哪款 AI 助手,它們都能接入標準化的工具目錄,隨時調用您需要的功能,正如今日任何品牌的裝置都能連接 Wi-Fi 或 USB 一般便利。

展望未來,AI 的應用邊界將持續擴張,而 MCP 這類標準化管道會是重要推手之一。Gartner 等機構預測未來企業在導入 AI 時,將越發重視工具和流程的標準化,以降低開發維護成本並確保安全合規。對企業而言,採用 MCP 意味著能在不同 AI 平台間移植整合成果、避免被單一生態鎖定;對開發者而言,學習並掌握 MCP 等標準能讓您的技能適用範圍倍增,開發的插件具備更長遠的生命力。可以想見,在「AI 無所不在」的願景下,MCP 這樣的通用協定將扮演不可或缺的角色——它不僅代表技術融合的進步,更代表著業界朝向開放協作、共通繁榮的理念邁進。

參考資料:

- McKinsey 全球調查揭示 2024 年初已有 65% 組織定期使用生成式 AI

- Gartner 調查顯示企業導入生成式 AI 可在未來一年節省約 15.7% 成本

- Anthropic 官方新聞:說明大型模型受限於資料孤島,每個資料源需客製整合的現況,以及 MCP 如何提供單一開放標準作為解方

- WorkOS 技術部落格:定義 MCP 為 Anthropic 開發的開放標準,連接 AI 助手與實際資料所在系統

- Anthropic 文件:將 MCP 比喻為 AI 應用的 USB-C 介面,提供標準化的連接方式

- WorkOS 技術部落格:白話解釋 MCP 架構中的 Client(AI 工具)與 Server(功能提供者)概念

- WorkOS 技術部落格:MCP 提供通用協定處理認證、政策與標準資料格式,取代即席的 API 連接器

- Ragie 技術文章:將傳統 API 比作各自的轉接頭,而 MCP 則是單一通用延長插座

- Ragie 技術文章:MCP 讓 AI 可動態探索外部系統而無需手寫粘合代碼

- Anthropic 官方新聞:說明 MCP 可一次整合,多處共用

- The Verge:Microsoft 採用與 ChatGPT 相同的插件標準

- Anthropic:MCP 伺服器範例(Google Drive、Slack、GitHub 等)

- Microsoft Windows 部落格:MCP 為 Windows AI 架構基礎

- Stytch 技術部落格:MCP 使用 JSON-RPC 與函式安全調用

- OWASP:列出大型語言模型應用十大安全風險

- Anthropic 官方新聞:MCP 三大開放元件與合作案例

- MCP GitHub 倉庫:協定文件與開發資源

- Forrester:AI 代理與工具整合的未來標準